Инструменты веб-скрейпинга специально разработаны для извлечения информации с веб-сайтов. Они также известны как веб-инструменты сбора извлечения данных. Эти инструменты полезны для тех, кто пытается собрать какую-либо форму данных из Интернета. Веб-скрейпинг — это новый метод записи данных, который не требует повторного набора текста или копирования.

Программное обеспечение для сбора данных ищет новые данные вручную или автоматически, извлекая новые или обновленные данные, а также сохраняя их для легкого доступа. Например, можно собирать информацию о продуктах и их ценах на Amazon с помощью инструмента для скрейпинга. В этом посте мы перечислим варианты использования инструментов и 10 лучших инструментов для сбора информации с нулевой необходимостью написания кода.

Почему инструменты веб-скрейпинга?

Инструменты веб-скрейпинга могут использоваться для неограниченных целей в различных сценариях, но мы расскажем об общих случаях использования, применимых к обычным пользователям.

1. Сбор данных для исследования рынка

Инструмент для сбора данных может помочь вам быть в курсе того, куда ваша компания или отрасль будет двигаться в ближайшие шесть месяцев, служа мощным инструментом для исследования рынка. Инструменты позволяют получать данные от нескольких поставщиков аналитической информации и фирм, занимающихся исследованием рынка, и объединять их в одном месте для удобства использования и анализа.

2. Извлечение контактной информации

Эти инструменты также могут использоваться для извлечения данных, таких как электронные адреса и номера телефонов с различных веб-сайтов, что позволяет получить список поставщиков, производителей и других лиц, представляющих интерес для вашего бизнеса или компании, наряду с их соответствующими контактными данными.

3. Загрузка решений из Stack Overflow

Используя инструмент веб-скрейпинга, можно также загружать решения для автономного чтения или хранения, собирая данные с нескольких сайтов (включая Stack Overflow и другие веб-сайты Q&A). Это снижает зависимость от активных подключений к интернету, поскольку ресурсы доступны, несмотря на наличие сети.

4. Поиск работы или сотрудников

Для компаний, которые активно ищут новых кандидатов в свою команду, или для соискателей, которые ищут определенную работу или вакансию, эти инструменты также отлично работают, помогая легко получать данные на основе различных применяемых фильтров и делать это эффективно без необходимости ручного поиска.

5. Отслеживание цен с нескольких рынков

Если вы занимаетесь онлайн-покупками и любите активно отслеживать цены на товары, которые вы ищете на разных рынках и в онлайн-магазинах, то вам определенно нужен инструмент для веб-скрейпинга в Интернете.

Лучшие инструменты для сбора данных

Давайте взглянем на 10 лучших инструментов для веб-скрейпинга. Некоторые из них бесплатны, а другие имеют пробные периоды и премиальные планы. Изучите детали, прежде чем подписаться на один из них для ваших потребностей.

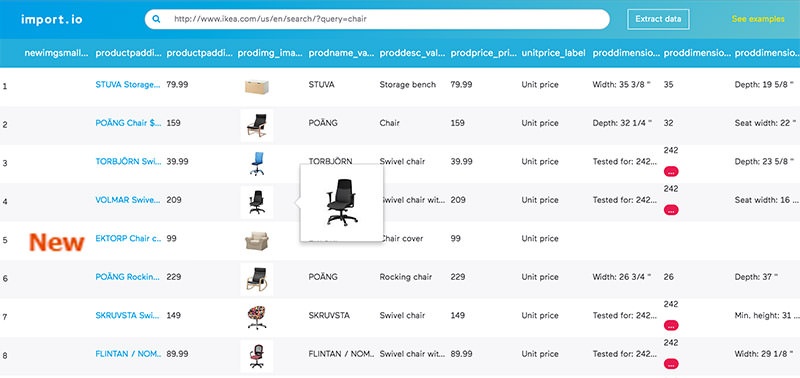

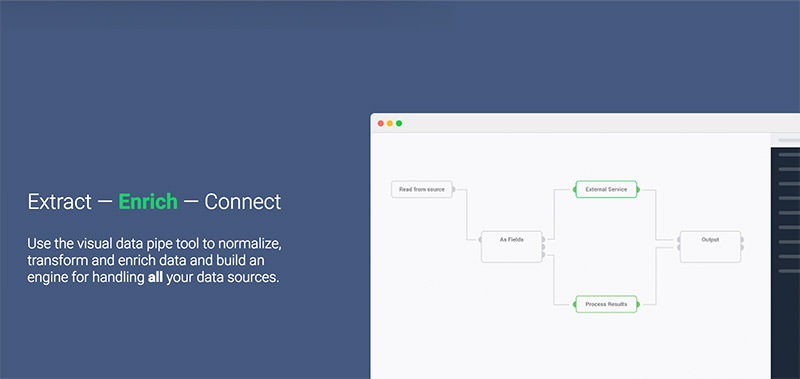

Import.io

Import.io предлагает конструктор для формирования ваших собственных наборов данных, просто импортируя данные с определенной веб-страницы и экспортируя их в CSV. Вы можете легко собрать данные с тысячи веб-страниц за считанные минуты без единой строчки кода и построить более 1000 API-интерфейсов на основе ваших требований.

Инструмент использует передовые технологии для получения миллионов данных каждый день, которые предприятия могут использовать за небольшую плату. Наряду с веб-инструментом, он также предлагает бесплатные приложения для Windows, Mac OS X и Linux, которые позволяют собирать и извлекать данные, загружать и синхронизировать их с онлайн-аккаунтом.

Webhose.io

Webhose.io предоставляет прямой доступ к структурированным данным в режиме реального времени, сканируя тысячи онлайн-источников. Инструмент поддерживает извлечение веб-данных на более чем 240 языках и сохранение выходных данных в различных форматах, включая XML, JSON и RSS.

Webhose.io — это веб-приложение на основе браузера, использующее эксклюзивную технологию сканирования данных для сбора огромных объемов данных из нескольких каналов в одном API. Он предлагает бесплатный план для 1000 запросов в месяц и премиальный план с ежемесячной платой 50 долларов на 5000 запросов в месяц.

Dexi.io (ранее известный как CloudScrape)

CloudScrape поддерживает сбор данных с любого веб-сайта и не требует загрузки, как Webhose. Он предоставляет браузерный редактор для настройки сканеров и извлечения данных в режиме реального времени. Вы можете сохранить собранные данные на облачных платформах, таких как Google Drive, или экспортировать их в формате CSV или JSON.

CloudScrape также поддерживает анонимный доступ к данным, предлагая набор прокси-серверов для скрытия вашей личности. Инструмент хранит ваши данные на своих серверах в течение двух недель перед их архивированием. Данный инструмент для веб-скрейпинга предлагает 20 бесплатных часов для сбора данных, после чего будет стоить 29 долларов в месяц.

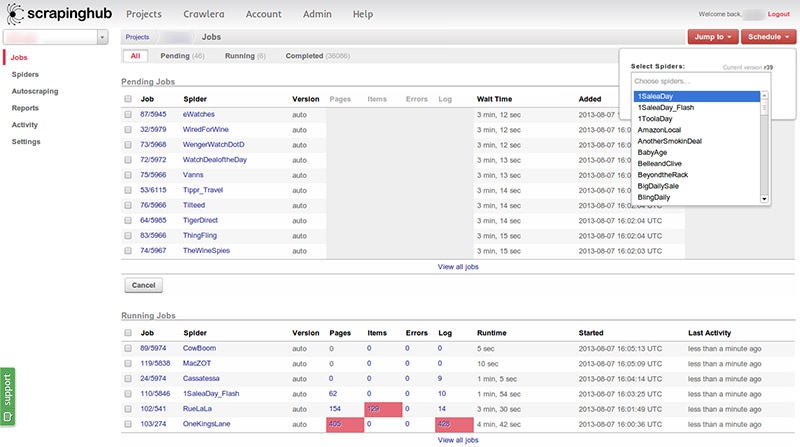

Scrapinghub

Scrapinghub — это облачный инструмент для извлечения данных, который помогает тысячам разработчиков получать ценные данные. Scrapinghub использует Crawlera, интеллектуальный прокси-ротатор, который поддерживает сканирование противодействий ботов для легкого сканирования огромных сайтов или страниц, защищенных ботами.

Scrapinghub преобразует всю веб-страницу в организованный контент. Группа экспертов всегда готова помочь, если ее конструктор сканирования не сможет удовлетворить ваши требования. Базовый бесплатный план дает вам доступ к одному одновременному сканированию, а премиум-план за 25 долларов в месяц обеспечивает доступ к четырем параллельным сканированиям.

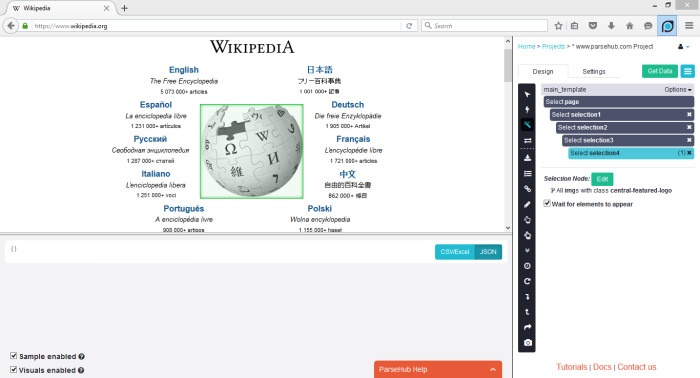

ParseHub

ParseHub создан для сканирования одного или нескольких веб-сайтов с поддержкой JavaScript, AJAX, сессий, файлов cookie и перенаправления. Приложение использует технологию машинного обучения для распознавания наиболее сложных документов в Интернете и создает выходной файл на основе требуемого формата данных.

ParseHub, кроме веб-приложения, также доступен в качестве бесплатного настольного приложения для Windows, Mac OS X и Linux, которое предлагает базовый бесплатный план, охватывающий пять проектов для сканирования. Этот сервис предлагает премиальный план за 89 долларов в месяц с поддержкой 20 проектов и 10 000 веб-страниц для сканирования.

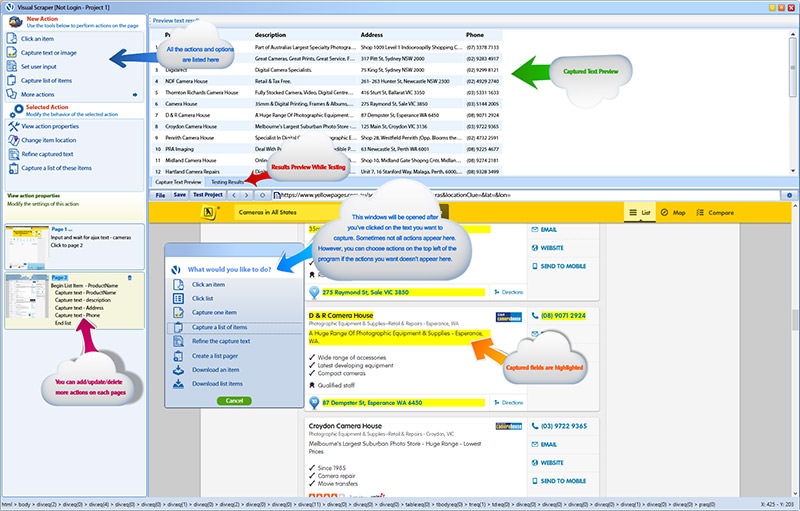

VisualScraper

VisualScraper — еще одно программное обеспечение для извлечения веб-данных, которое можно использовать для сбора информации из Интернета. Программное обеспечение помогает вам извлекать данные с нескольких веб-страниц и получать результаты в режиме реального времени. Кроме того, вы можете экспортировать полученные данные в различные форматы, такие как CSV, XML, JSON и SQL.

Вы можете легко собирать и управлять веб-данными с помощью простого и удобного интерфейса. VisualScraper поставляется в бесплатных, а также премиальных планах, начиная с 49 долларов в месяц, с доступом к более 100 тысячам страниц. Бесплатное приложение, похожее на Parsehub, доступно для Windows с дополнительными пакетами C ++.

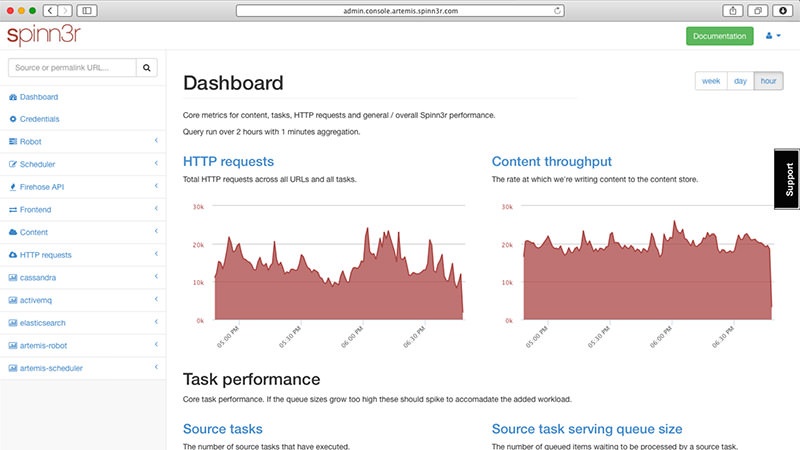

Spinn3r

Spinn3r позволяет получать целые данные из блогов, новостных сайтов и сайтов социальных сетей, а также каналов RSS и ATOM. Spinn3r поставляется с API Firehouse, который управляет 95% работ по индексированию. Он предлагает расширенную защиту от спама, которая удаляет спам и неуместное использование языка, тем самым повышая безопасность данных.

Spinn3r индексирует контент, аналогично Google, и сохраняет извлеченные данные в файлы JSON. Инструмент постоянно сканирует сеть и находит обновления из нескольких источников, чтобы получать публикации в реальном времени. Консоль администратора позволяет контролировать сканирование, а полнотекстовый поиск дает возможность выполнять сложные запросы к необработанным данным.

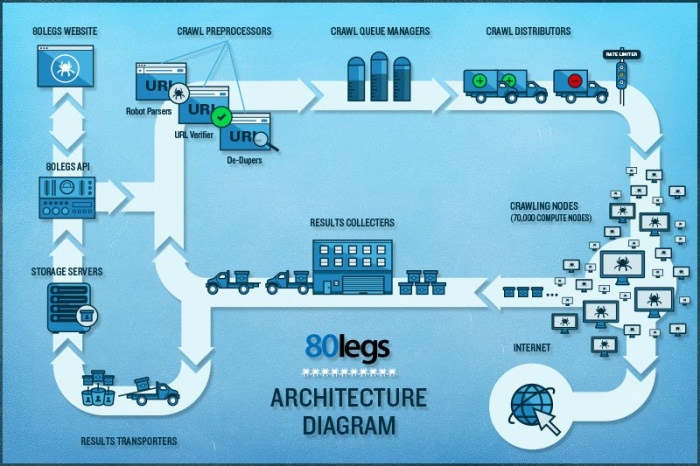

80legs

80legs — это мощный, но гибкий инструмент для сканирования веб-страниц в Интернете, который можно настроить в соответствии с вашими потребностями. Он поддерживает извлечение огромных объемов данных, а также возможность мгновенной загрузки извлеченных данных. Разработчики инструмента утверждают, что он сканирует более 600 000 доменов и используется такими крупными компаниями, как MailChimp и PayPal.

Его ‘Datafiniti‘ позволяет быстро искать все данные. 80legs обеспечивает высокопроизводительное сканирование в Интернете, которое работает быстро и извлекает необходимые данные за считанные секунды. Вам предлагается бесплатный план на 10 000 URL-адресов для сканирования, который может быть обновлен до премиального плана за 29 долларов в месяц на 100 000 URL-адресов для сканирования.

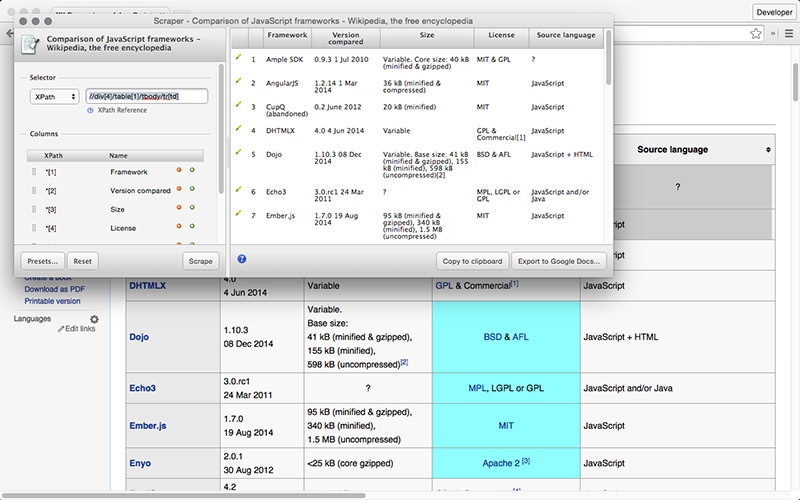

Scraper

Scraper — это расширение для Chrome с ограниченными функциями извлечения данных, но оно полезно для онлайн-исследований и экспорта данных в электронные таблицы Google. Этот инструмент предназначен для начинающих, а также экспертов, которые смогут легко копировать данные в буфер обмена или сохранять в электронных таблицах с помощью OAuth.

Scraper является бесплатным инструментом, который работает прямо в вашем браузере и автоматически генерирует меньшие XPath для определения URL для сканирования. Он не предлагает простоты автоматического сканирования или сканирования ботов, как Import, Webhose и другие, но он довольно полезен для новичков, так как вам не придется разбираться с запутанной конфигурацией.

Всем успешной работы и творчества!

0 комментариев